ビジネスを成長させ、成功に導くためには、データ分析基盤サービスの選択が重要です。しかし、多くのサービスがあり、どれを選べばいいのか迷っている方もいるのではないでしょうか?

本記事では、データ分析基盤の役割から選定のポイント、具体的なシーン別の選定方法を解説します。データ分析基盤の選定から活用までの情報を詳しく解説していますので、ぜひ最後までご覧ください。

データ分析基盤の概要と役割、メリット

データ分析基盤とは、企業が保有する大量のデータを一元的に管理し、それを分析するための基盤のことです。これを活用すると、データを基にビジネスの意思決定を行うことが可能となります。

売上データの分析を例に挙げると、どの商品がよく売れているのか、どの地域で売れているのかといった情報を得ることができます。さらに、顧客の購買履歴の分析により、顧客の購買傾向や好みを把握し、パーソナライズされたマーケティング戦略を立てることも可能です。

また、製造業であれば、生産データを分析することで、生産効率の改善点や、製品の品質管理に役立つ情報を得ることができます。さらに、社内の業務データを分析することで、業務の効率化や業績の改善につながる有益な情報や発見を見つけ出すことも可能です。

これらの例からもわかるように、データ分析基盤は、企業がビジネスを成長させるための重要なツールとなります。

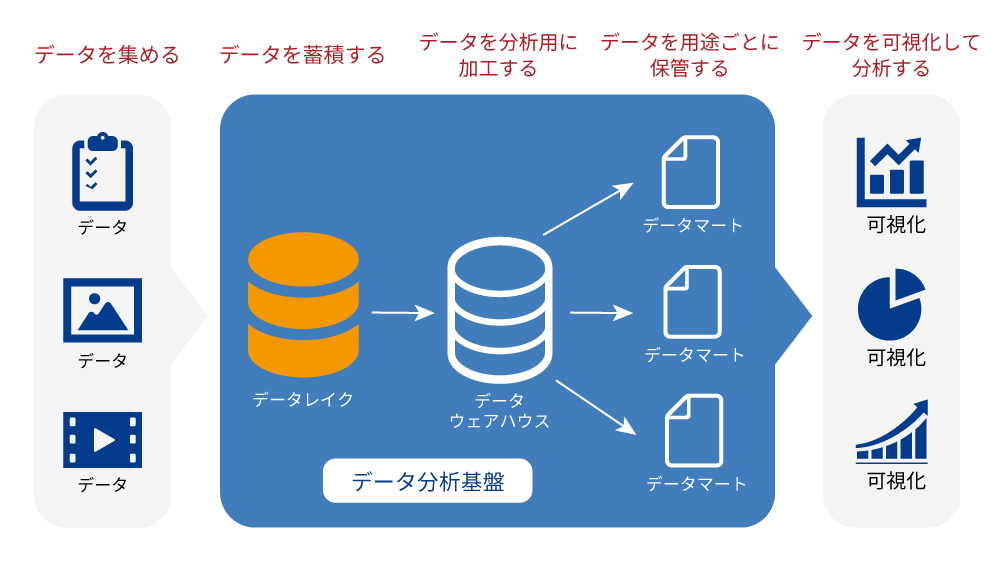

データ分析基盤の基本的な構成

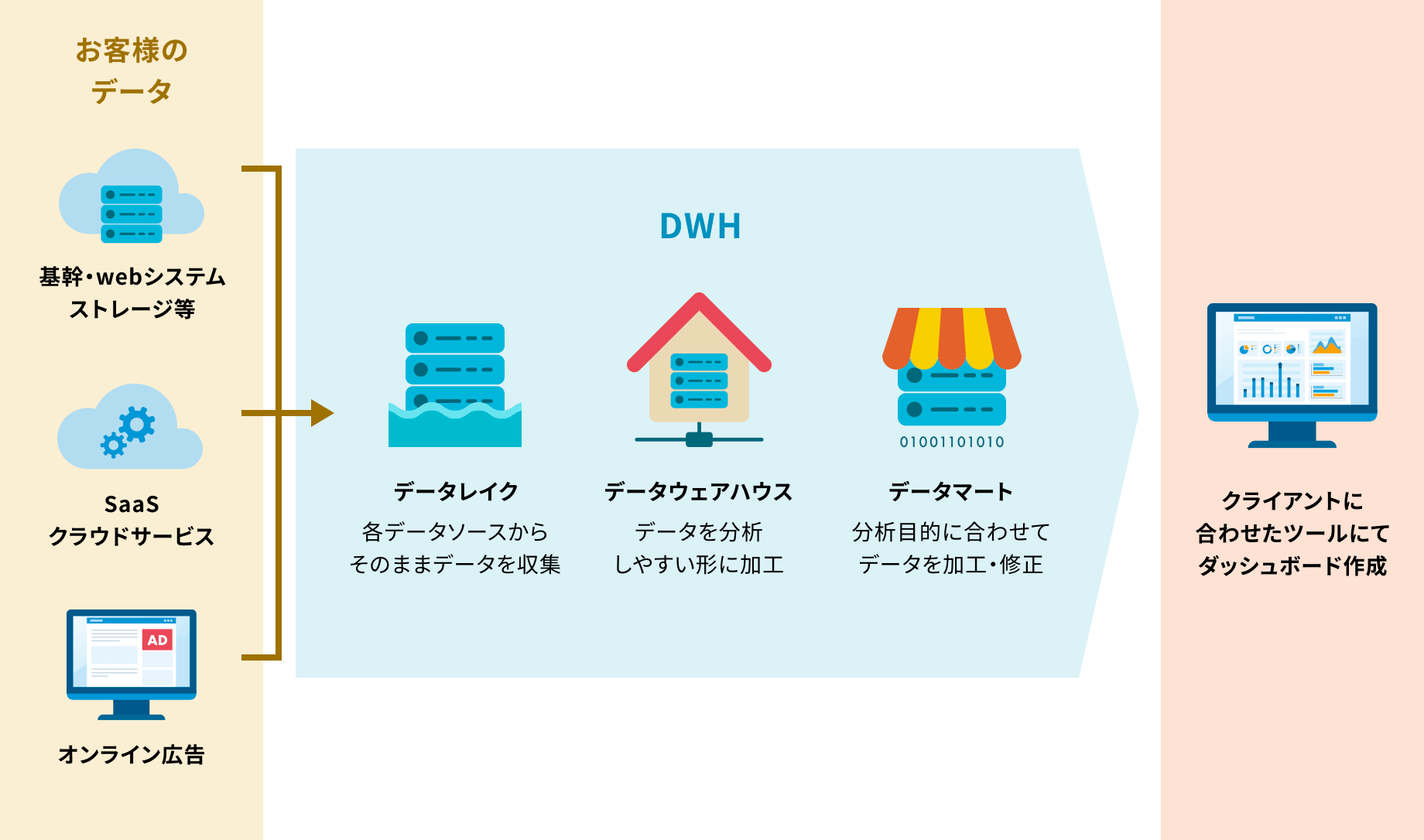

データ分析基盤は大きく分けて、データの収集・保存を行う「データレイク」、データを整形・加工・クレンジングする「データウェアハウス」、そして特定のビジネス要件に合わせてデータを整理・保管する「データマート」の3つから構成されます。それぞれの役割と特性について詳しく見ていきましょう。

データレイク

データレイクは、企業が保有する様々なデータを「生の」状態、つまり加工や変換を行わずにそのまま一元的に収集・保存するためのシステムです。これにより、データが分散して管理されることを防ぎ、新たなデータソースが追加された場合でも柔軟に対応できます。

また、データレイクは構造化データ(例:データベースのテーブル)、半構造化データ(例:JSONやXML)、非構造化データ(例:音声や画像)など、あらゆる種類のデータを収集・保存が可能です。

さらに、データを「生の」状態で保存することで、データが元々持っていた全ての情報が保持されるので、後からデータを再分析することもできます。

データウェアハウス

データウェアハウスは、データレイクからデータを取り出し、ビジネスの意思決定に役立つ形に整形・加工・クレンジングするシステムです。データウェアハウスの主な役割は、データの一貫性と整合性を保つことで、データが信頼性の高い状態で保存されます。

これにより、ユーザーはそのデータを使用して分析や意思決定を行うことができます。

また、データウェアハウスは、データの構造化とインデックス作成を行うことで、大量のデータから必要な情報を迅速に取り出し、高速なデータ検索と分析を可能にします。

データマート

データマートは、データウェアハウスから特定の用途で必要とするデータを取り出し、それを保管するための場所です。用途としては、可視化を担うBIダッシュボードのデータソースとなる場合が多いです。

例えば、マーケティング活動で必要とする「顧客の購買傾向データ」や「市場の動向データ」など、データウェアハウスから取り出し、集計した結果をマーケティング用のデータマートに整理し、保管します。

これにより、マーケティング活動を行う際に必要なデータに迅速にアクセスできるようになります。

これらの要素は、データの収集から分析までのプロセスを効率的に行うための基盤となります。それぞれの要素は、特定の目的と役割を持っており、それぞれが連携してデータ分析基盤全体を構成します。

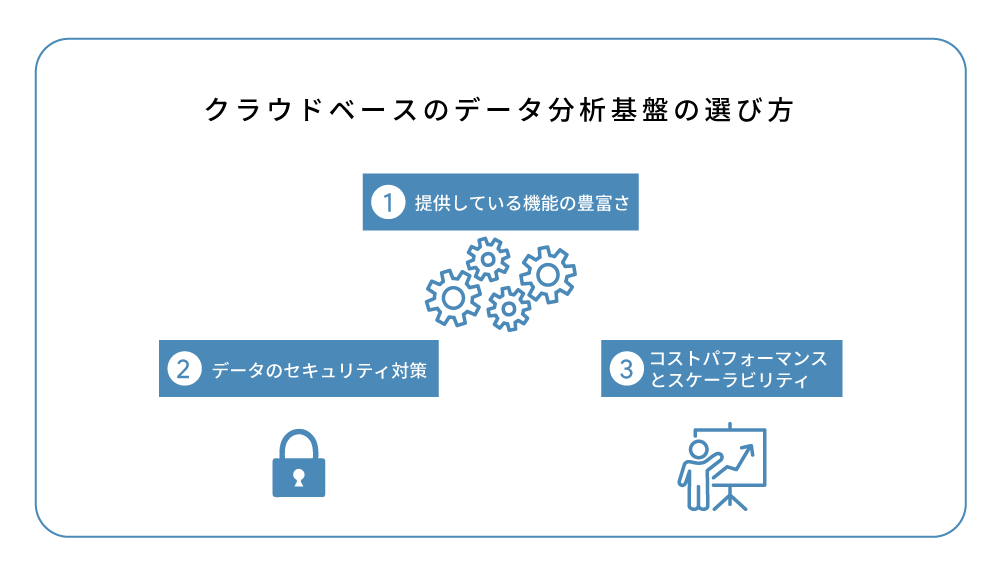

クラウドベースのデータ分析基盤の選び方

データ分析基盤の選定ポイントについて見ていきましょう。

かつてはオンプレミス基盤が主流でしたが、ハードウェアの調達やメンテナンス、スケーラビリティなどの面で多くの制約がありました。これらの手間や障壁を大きく低減させるクラウドベースの基盤が今後の主流になるでしょう。ここで、クラウドベースのデータ分析基盤の選び方から、選定における重要な要素、そして構築時のポイントまでを詳しく解説します。

クラウドベースのデータ分析基盤は、初期投資を抑えつつ、必要に応じてスケールアップすることが可能です。

選び方のポイントとしては、

- 提供している機能の豊富さ

- データのセキュリティ対策

- コストパフォーマンスとスケーラビリティ

が挙げられます。

提供している機能の豊富さ

データ分析基盤を選ぶ際には、データの種類や分析の目的に応じて、必要な機能が全て揃っているかを確認することが重要です。例えば、リアルタイム分析が必要な場合、その機能を提供しているかどうかをチェックする必要があります。

また、AIや機械学習を活用した高度な分析が可能な基盤も存在します。これらの技術を活用することで、大量のデータから複雑なパターンを見つけ出したり、未来の予測を行ったりすることが可能となります。

これにより、ビジネスの意思決定がよりスムーズになり、競争力を強化することができます。

データのセキュリティ対策

クラウドサービスでは、データが外部のサーバーに保存されるため、データの漏洩や不正アクセスを防ぐためのセキュリティ対策が万全であることが求められます。

具体的には、データ暗号化、アクセス制御、監査ログの提供、セキュリティ認証などの機能が備わっているかを確認することが重要です。

コストパフォーマンスとスケーラビリティ

初期投資を抑えられるクラウドベースのデータ分析基盤でも、使用量に応じた料金が発生するため、そのコストと提供される機能・性能がバランス良く整っているかを確認しましょう。

また、ビジネスの成長やデータ量の増加に応じて、システムをスケールアップすることが可能かどうかも重要な選定ポイントです。

これにより、初期投資を抑えつつ、必要に応じてシステムを拡張することが可能となります。

これらのポイントを踏まえてクラウドベースのデータ分析基盤を選定することで、ビジネスの成長に合わせた柔軟なデータ分析が可能となります。

次に、より具体的なデータ分析基盤選びで重要となる要素について見ていきましょう。

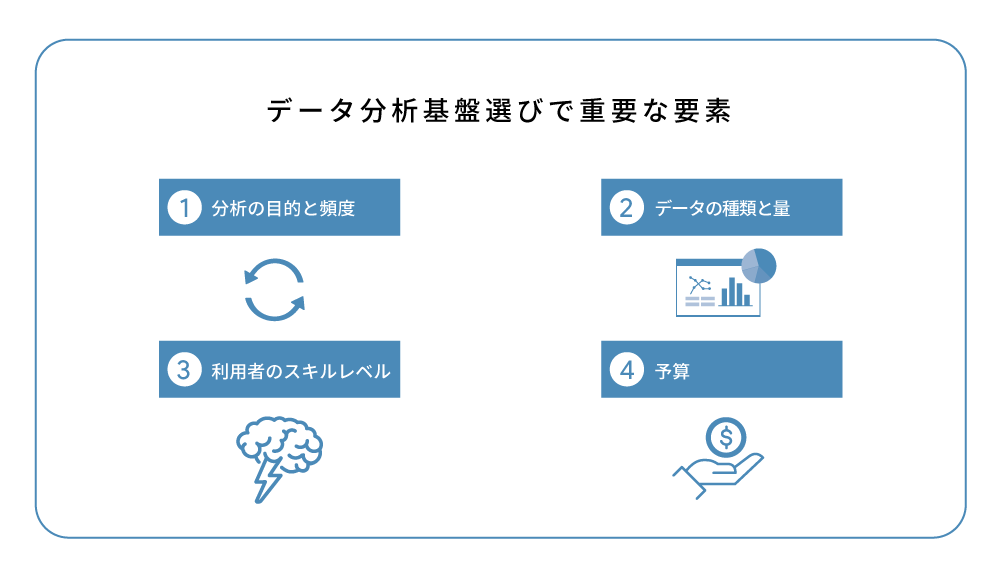

データ分析基盤選びで重要な要素

データ分析基盤選びにおける重要な要素を以下の4つに分けて解説します。

- 分析の目的と頻度

- データの種類と量

- 利用者のスキルレベル

- 予算

それぞれの要素が選定にどのように影響するのかを理解しましょう。

分析の目的と頻度

分析の目的と頻度によって、必要な機能や性能が変わります。例えば、リアルタイムでの分析が必要な場合は、高速なデータ処理能力を持つ基盤が適切です。

また、頻繁に大量のデータを分析する必要がある場合は、大量のデータを迅速に処理できる性能が必要となります。

一方、特定の問いに対する答えを見つけることが目的の分析、例えば「顧客の購買傾向は何か?」や「製品の売上予測はどうなるか?」といった問いに対しては、それぞれ顧客データ分析機能や予測分析機能を持つ基盤が最適といえるでしょう。

データの種類と量

データの種類と量も基盤選定の重要な要素です。大量のデータを扱う場合や、様々な種類のデータを扱う場合は、それに対応した基盤を選びましょう。

例えば、テキストデータ、画像データ、音声データなど、データの種類によっては特定の分析手法やストレージが必要です。

また、データ量が多い場合は、データの保存、管理、分析が効率的に行える基盤を準備しましょう。

利用者のスキルレベル

データ分析基盤を操作するスタッフのスキルレベルも考慮することをおすすめします。専門知識がないスタッフでも操作できるような、直感的なインターフェースを持つ基盤を選ぶと良いでしょう。

また、スタッフがデータ分析の専門家であれば、高度な分析機能を持つ基盤を選ぶことも考えられますが、その場合でも操作性や学習コストを考慮することが重要になります。

予算

最後に、予算も重要な選定要素になります。予算内で、必要な機能要件を満たしつつ、最も性能と機能が優れた基盤を選ぶことが理想的です。安価な基盤を選んだ結果、必要な機能が揃わなかったり、性能が不足していたりすると、結果的にコストがかさむこともあります。

また、コストは初期投資だけでなく、運用コストも考慮する必要があります。例えば、システムの保守やスタッフの教育など、運用に伴うコストも見積もりに含めることが重要です。

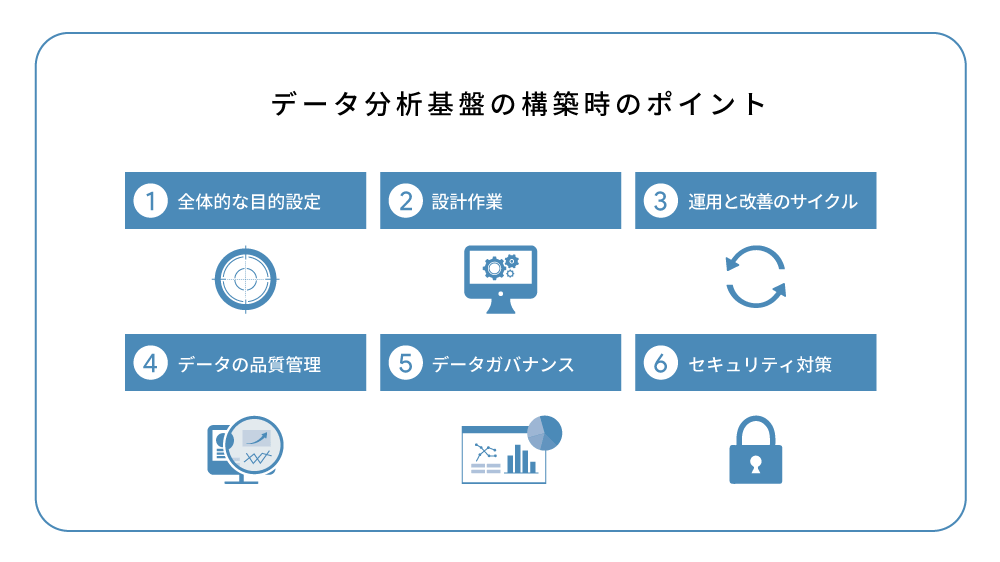

データ分析基盤の構築時のポイント

データ分析基盤の構築時には、以下の6つのポイントを考慮する必要があります。これらを理解し、適切な基盤構築を行いましょう。

全体的な目的設定

データ分析基盤を構築する際には、全体的な目的を設定することが重要です。その目的により、どのような基盤を構築すべきか、どのような機能が必要かが明確になります。

例えば、新製品の市場反応を予測するためのデータ分析基盤を構築する場合、目的は「新製品の市場反応を正確に予測する」ことになります。この目的に基づき、以下のような要素が必要となります。

| 必要なデータの種類 | 顧客データ、新製品に関するデータ、市場データ、ソーシャルメディアデータなど。 |

| 分析手法 | 予測モデリングや顧客セグメンテーションなど。 |

| 必要な機能 | データ収集と統合、データクリーニング、データ分析、レポートとダッシュボードの作成など。 |

| 必要なデータの種類 | 顧客データ、新製品に関するデータ、市場データ、ソーシャルメディアデータなど。 |

| 分析手法 | 予測モデリングや顧客セグメンテーションなど。 |

| 必要な機能 | データ収集と統合、データクリーニング、データ分析、レポートとダッシュボードの作成など。 |

これらの要素を明確にするためには、まず全体的な目的設定が不可欠です。目的が明確であればあるほど、必要なデータの種類、分析手法、必要な機能が明確になり、効率的かつ効果的なデータ分析基盤を構築することが可能になります。

設計作業

設計作業では、データの収集・整理・保存の方法、分析の方法、データの管理方法などを決定します。全体的な目標に基づいてこれらの作業を進めることが大切です。

具体的なデータの流れを設計し、どのようなデータをどのように処理するかを明確にするのが設計作業の一部です。さらに、データのバックアップやリカバリーの計画もこの段階で考慮が必要となります。

運用と改善のサイクル

データ分析基盤は、一度構築したら終わりではありません。運用しながら、必要に応じて改善を行うサイクルをまわすことが重要です。データの量や種類、ビジネスの状況は常に変化するため、それに対応するためにも基盤の改善は必須です。

具体的には、分析手法の改善が求められることがあります。新たなアルゴリズムの導入や既存のアルゴリズムのパラメータ調整などにより、より高精度な予測や洞察を得ることが可能になります。

また、基盤のパフォーマンス改善も重要です。データ量の増加や処理速度の要求に応じて、ストレージの拡張や計算能力の強化などが必要となることがあります。

これらの改善活動を継続的に行うことで、データ分析基盤は常に最適な状態を保つことができ、変化するビジネス環境に柔軟に対応することが可能となります。

データの品質管理

データの品質管理は、データ分析の精度を保つために不可欠です。データの整合性を保つためのルールを設け、それを遵守する体制を作ることが求められます。

具体的には、データの入力ルール、データクレンジングの方法、データの更新頻度などを定め、それを遵守する体制を作ります。

具体的には、以下のようなルールを設けます。

| データの入力ルール | データの入力には一貫性と正確性が求められます。例えば、日付の入力形式を「YYYY-MM-DD」に統一する、電話番号はハイフンなしの数字のみを許可するなど、特定の形式や規則を設けることが重要です。 |

| データクレンジングの方法 | データクレンジングは、不正確なデータや欠損データを修正または削除するプロセスです。 例えば、欠損値の扱い方を定める(欠損値をそのままにする、平均値で補完する、削除するなど)、異常値の検出と修正方法を定めるなどのルールが必要です。 |

| データの更新頻度 | データの新鮮さは、分析結果の有用性に直結します。データの更新頻度を定め、それを遵守することが重要です。 例えば、リアルタイムに近い分析が必要な場合は、データの更新を日次または時次で行うといったルールを設けます。 |

| データの入力ルール | データの入力には一貫性と正確性が求められます。例えば、日付の入力形式を「YYYY-MM-DD」に統一する、電話番号はハイフンなしの数字のみを許可するなど、特定の形式や規則を設けることが重要です。 |

| データクレンジングの方法 | データクレンジングは、不正確なデータや欠損データを修正または削除するプロセスです。 例えば、欠損値の扱い方を定める(欠損値をそのままにする、平均値で補完する、削除するなど)、異常値の検出と修正方法を定めるなどのルールが必要です。 |

| データの更新頻度 | データの新鮮さは、分析結果の有用性に直結します。データの更新頻度を定め、それを遵守することが重要です。 例えば、リアルタイムに近い分析が必要な場合は、データの更新を日次または時次で行うといったルールを設けます。 |

これらのルールを遵守する体制を作ることで、データの品質を維持し、データ分析の精度を保つことが可能になります。

参考記事:データクレンジングとは?重要性とやり方をわかりやすく解説

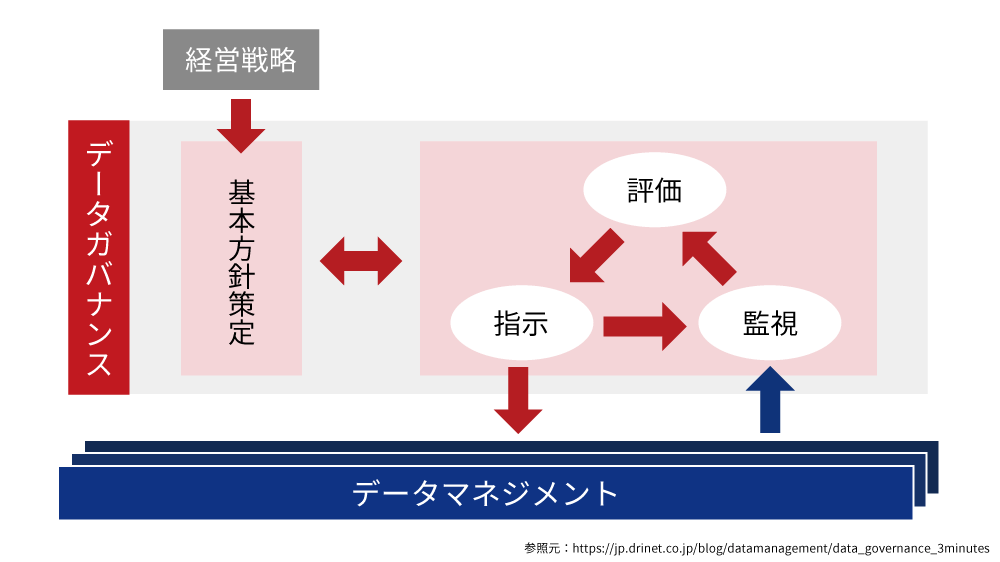

データガバナンス

データ分析基盤を構築する際には、データガバナンスが重要です。データガバナンスは、データの所有権や利用権、データに関するルールやポリシーを管理するプロセスを指します。これは、データの適切な利用と保護を実現するための重要な要素です。

データガバナンスの取り組み方としては、まずデータの所有権、利用権、保管・廃棄に関するポリシーを明確に定義します。次に、データへのアクセス制御を厳格に行い、ロールベースのアクセス制御を実装します。さらに、データの利用状況を監査・モニタリングし、不正アクセスやデータ漏洩のリスクを低減します。

これらの取り組みは、データの価値を保ちながら法律や規制の遵守、企業のリスク管理を支援し、効率的なデータ分析基盤を構築する助けとなります。

参考記事:データガバナンスとは?必要性や実現方法から成功事例まで

セキュリティ対策

データは企業の重要な資産です。そのデータを保護するためのセキュリティ対策は必須です。データの漏洩や改ざんを防ぐための対策をしっかりと行いましょう。

具体的には、データのアクセス権限の設定、データの暗号化、セキュリティ対策のためのシステムの導入などが必要となります。

シーン別のデータ分析基盤サービスの選定

データ分析基盤の選定は、ビジネスのシーンによっても変わります。ここでは、以下のポイントについて解説します。

- スモールスタート

- スケールアップを考慮

- リアルタイム分析

- 特定の業界や業種

スモールスタートの場合の選定ポイント

スモールスタートの場合、初期投資を最小限に抑えつつ、必要に応じてスケールアップ可能なクラウドベースのデータ分析基盤が最適です。

この観点から、Snowflakeを推奨します。Snowflakeはクラウドベースのデータ分析基盤で、初期投資を抑制しつつ、必要に応じてリソースをスケールアップすることが可能です。さらに、他のサービスとの連携がスムーズで、操作も簡単です。

一方で、BigQueryやRedshiftも優れたデータ分析基盤ではありますが、導入や運用が少々複雑であるため、スモールスタートの際にはSnowflakeがより適していると言えます。

スケールアップを考慮した場合の選定ポイント

スケールアップを考慮する場合、大量のデータを高速に処理できる基盤の選定が重要となります。また、データの種類が増える可能性も考慮に入れ、多様なデータを扱える基盤の選択が望ましいです。

具体的な基盤の選定について考えると、以下のような選択肢が考えられます。

分析データが分散されている場合

Snowflakeは、大量のデータの保有やサービスリリース後の大量データ取得を想定する場合に適しています。特に、分析するデータが分散している場合、Snowflakeのマルチクラウド対応が強みとなります。AWS、Azure、GCPなど、複数のクラウドプロバイダ上で動作するため、異なるクラウド環境間でのデータの移動や統合が容易になります。

分析データが集中化されている場合

集中化されたデータを扱う場合、Redshift、BigQuery、Azure Synapse Analytics、snowflake などのデータウェアハウスソリューションを検討することをおすすめします。これらのソリューションはそれぞれが独自の強みを持ち、組織の要件や目的に応じて選定することが重要です。

以上のようなポイントを考慮し、データ分析基盤を選定しましょう。

リアルタイム分析が必要な場合の選定ポイント

リアルタイム分析が必要な場合、高速なデータ処理能力を持つ基盤の選定が重要となります。リアルタイム分析では、データを即時に処理し、結果を提供する能力が求められます。

そのため、リアルタイム分析に適した機能を持つ基盤の選択が必要です。具体的には、ストリーミングデータの処理や、リアルタイムでのダッシュボード更新などの機能が必要となります。

さらに、大量の処理要求に対応するための高い信頼性、可用性、そして拡張性も重要な要素となります。これらの要件を満たすことで、ビジネスの成長や変化に柔軟に対応し、サービスの中断なくスムーズな分析を継続することができます。

組織的に属人的にならないためにも

- データのサイロ化

- ツールの複雑性

を回避して、シンプルな分析環境の実現も重要です。

以上を加味すると、筆者としては、BigQuery 、Snowflake が機能的な優位性からおすすめです。サーバーレスの特性により、インフラの管理が不要で、大量のデータも高速なSQLクエリでリアルタイムに分析可能です。さらに、ストリーミングデータの即時処理もサポートしており、ビジネスの状況をリアルタイムで把握し、迅速な意思決定をサポートします。

ただし、しっかりとした設計が必要となりますので、リアルタイム分析基盤の構築から分析環境の設計、データの可視化までプロジェクトを推進したことがある人材が社内にいない場合は、外部の専門家に相談する方が良いでしょう。

まとめ

データ分析基盤の選定には、分析の目的や頻度、データの種類や量、利用者のスキルレベル、予算など、様々な要素を考慮する必要があります。また、データ分析基盤の構築には、全体的な目標設定から設計作業、運用と改善のサイクル、データの品質管理、データガバナンス、セキュリティ対策など、多くのポイントが存在します。

これらを踏まえ、自社のビジネスに最適なデータ分析基盤を選定しましょう。その際、弊社では、Snowflakeは、高機能性と利便性を備えたデータ基盤サービスであるため、優れた選択肢となる可能性があると考えております。

Snowflakeは、アプリケーションの開発、データシェアリング、ニアゼロメンテナンスといった特徴を有し、データ分析基盤としての高いパフォーマンスを発揮します。SaaS型のサービスとして、さまざまなデータ連携が容易に行えるため、データのサイロ化も効果的に改善・防止することができます。

また、主要なクラウド上で利用可能であり、データウェアハウジングからデータレイク、AIと機械学習まで、幅広いワークロードをサポートしています。

これらの特性を考慮に入れて、Snowflakeをデータ分析基盤の選定に検討することをお勧めします。

最後に弊社からのお知らせです。

データ活用の、こんなお悩みございませんか?

- 何から始めればいいのかわからない

- 分析してみたいけど方法が分からない

- データ活用のメリットが社内で認知されていない

以上のお悩みの方へ 弊社は、貴社がデータ活用をもっと簡単に・スピーディーに始めるための支援をしております。

データ基盤の構築だけにとどまらず

- 貴社独自のダッシュボードの作成

- 施策改善までサポート

- 企業・事業の成長に合わせたカスタマイズ

まで一気通貫でサポートできるのが弊社の強みです。

もちろん貴社のビジネス状況のヒアリングをしっかりと行いますので、どんなデータを収集したら良いのか?困っているあなたもご安心ください。

また、低価格&時短で分析基盤の構築が可能ですので、ミニマムからデータ分析を実施したい企業様におすすめです。

※弊社サービスQuida(クイーダ)を使用した場合

- データ基盤の構築だけ

- データ活用のコンサルティングだけ

- 一気通貫でのトータルサポート

貴社の状況に合わせたサポートが可能ですので、まずはお気軽にご相談ください。